hotline

400-9904-119集微网报道(文/李映)致力于让AI无处不在——从云到网络、再到边缘和PC已成为英特尔的新愿景。在这一愿景指引下,英特尔正在持续打造全栈软硬件实力。

在英特尔执行副总裁兼数据中心和AI事业部总经理Sandra Rivera看来,AI正在改变每个行业,到2026年全球AI支出预计将超过3000亿美元。

Sandra Rivera进一步指出,随着AI模型在云、边缘和客户端环境中的部署加快,混合AI将可应用边缘、客户端或云端的计算资源来创建基于AI模型的无缝体验,运行这些AI模型的异构芯片变得更具战略意义,英特尔提供包括至强、酷睿、Gaudi以及Flex和Max 系列GPU等可扩展的AI基础设施。而且英特尔正在加快构建一个开放的AI软件ECO,着力促进AI在多样工作负载中的部署和访问。

特别是随着生成式AI爆火以来,AI模型所需的算力更是呈现出爆发式增长的态势。为致力于为数据中心、云、网络和边缘带来更强大的AI功能,英特尔在第四代英特尔至强可扩展处理器Sapphire Rapids取得百万级出货量的战绩下,再次祭出软硬件全新“升级”的第五代至强可扩展处理器。凭借着更多内核数量、更大缓存、AI加速器、软件优化等创新,英特尔称其为史上最强AI处理器,将为AI无处不在注入“新动能”。

正如英特尔副总裁兼至强产品和解决方案事业部总经理Lisa Spelman所言,英特尔始终对至强进行持续的硬件创新和软件增强优化,第五代至强可扩展至强处理器——Emerald Rapids是专为AI而设计的处理器。

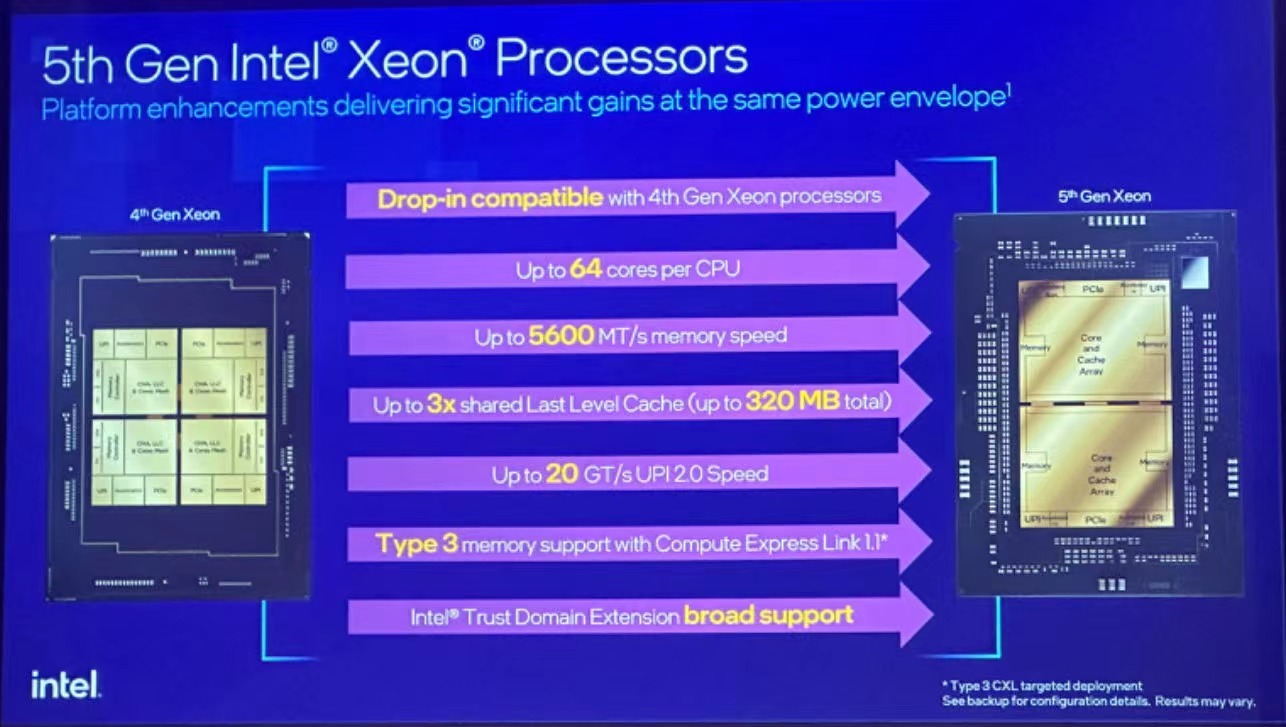

从架构来看,基于Raptor Cove的P-Core性能核心和LGA 4677插槽,实现了更优化的设计,从4-tile转变为 2-tile 设计,核心数量达64个,成为拥有核心数最多的处理器。三级缓存容量增至320MB,旗舰芯片Xeon 8592+缓存高达448MB。这在某种程度上预示着在对于服务器和工作站等高性能计算应用场景处理复杂和大量的计算任务时,这款处理器可以有明显效果地地减少数据访问延迟,提升整体性能表现。通过在每个核心中内建AI加速的Intel AMX,逐步提升了推理和训练方面的表现,以及更低的总体拥有成本(TCO)。此外,对内存的支持从DDR5-4800提高到DDR5-5600,且提供CXL 1.0/2.0的支持以及多达80条PCIe 5.0通道,带来了更高的带宽和传输速度,有助于实现工作负载优化的效能和节能计算。

据悉,全新第五代英特尔至强可扩展处理器更是能够微调参数量多达200亿的大语言模型9,并将其推理性能提高42%。现阶段,英特尔至强可扩展处理器也是唯一一款拥有MLPerf训练和推理基准测试结果并持续提升性能的CPU。

此外,第五代至强可扩展至强处理器引人关注的革新之一无疑是从4-tile转变为 2-tile 设计,对此英特尔资深院士Sailesh Kottapalli解读说,这可实现更好的核心数量、更好的能效、更好的延迟、更大的缓存,同时集群设计时可实现更好的打包和更低的性能抖动。而更大的LLC带来更好的延迟,并实现了虚拟机之间的隔离效果更佳。

Lisa Spelman以数字为例说,第五代至强的AI推理性能提高了42%,通用计算性能提升21%,在全负荷运行时提高了36%的效率。此外,通过软件优化带来的性能提升也值得关注。

在开放软件生态层面,第五代至强处理器也实现了新的“进化”。据悉,Emerald Rapids非结构化稀疏度高达50%,支持超 300个深度学习模型以及其他机器学习和图模型,可使应用的框架和库利用最大化。

英特尔网络与边缘事业部软件工程首席副总裁兼总经理Andres Rodriguez具体介绍说,第五代至强为大语言模型提供了加速,并满足了大部分市场大语言模型部署的延迟需求,不仅支持客户使用PyTorch或TensorFlow、OpenVINO的AI软件,可在云端和企业环境中无缝运行,也支持英特尔最新的优化。在BERT-large基准测试中,软件加速为第五代至强实现了24%的性能增益。

针对大语言模型的快速应用,Andres Rodriguez进一步提到,有一些大型大语言模型需要像Gaudi2这样更专业的AI加速器,但模型扩大到40B并增加批量大小以提高吞吐量时,至强可通过额外的服务器满足所需的延迟要求。对于具有70B参数的较大模型,可通过四台服务器来满足延迟目标。

整体而言,相比第四代至强,Emerald Rapids整体性能提升1.21倍、推理速度提升了1.4倍、高性能算力提升1.4倍,吞吐量提升1.7倍。

“第五代至强可扩展处理器通过上述创新,可提供更高的计算能力和卓越的AI性能,为一系列AI工作负载训练和推理提供显著的性能提升,无论是图像识别、计算机视觉、物体检测等等,有助于推动AI无处不在。”Lisa Spelman强调说。

Lisa Spelman进一步表示,至强处理器一直是虚拟化云数据中心的基础,英特尔还期待其在AI基础方面发挥同样重要的作用,从云和网络到客户端、边缘都能一展所长。

第五代至强在上述层面全新“晋级”,也为解决数据中心挑战提供了全新的“战斗力”。

“随着AI技术令人惊叹的创新浪潮席卷全球,如图像识别、推荐系统、NLP以及现在的生成式AI等。客户希望AI能够推动真正的业务发展,而每个行业都释放创造力。”Lisa Spelman认为,“无论部署如何,云架构的价值都源于需要灵活性、效率和较低的总体拥有成本,第五代至强在性能、TCO和功耗层面都可满足上述需求,能够说是专为AI而生的处理器。”

英特尔资深院士Ronak Singhal指出,随着大模型规模的逐步扩大,部署AI相关的成本不断的提高,此外安全挑战也不容忽视,总拥有成本、效率和安全成为现阶段数据中心客户面临的主要挑战。英特尔旨在通过AI产品和解决方案着力解决上述挑战,从而助力客户成功部署AI。

与此同时,第五代至强与第四代至强不仅在平台上具备兼容性,在AI、科学计算、数据库、网络、存储和安全等领域提供强劲的AI性能,加以开箱即用效率的大幅度的提高,能够显著减少数据中心的运营支出。Lisa Spelman提到,对于遵循典型的五年更新周期并从更前一代处理器进行升级的客户而言,总体拥有成本最多降低77%。IBM发现,与上一代英特尔至强可扩展处理器的测试数据相比,第五代英特尔至强可扩展处理器在其watsonx.data平台上的网络查询吞吐量提高了2.7倍。

此外,可持续性是数据中心的一大重要的条件,英特尔通过优化电源模式等功能在数据中心的典型利用率上减少电力和冷却成本。Ronak Singhal提到,通过这一革新,整个负载线%,整个吞吐量负载线%,在客户使用水平下架构改良带来的25-50%的利用率提升,在工作负载利用率上提供了性能/功率增益。

安全性无疑是数据中心尤其是云使用模型信任的基础。Ronak Singhal提及,从数据安全的方面出发,有两种互惠共赢的方式:其一,是“AI for Security”,即利用AI来提升产品、服务和解决方案的安全性和隐私性,英特尔威胁检测技术TDT可在CPU微架构上尝试执行时识别并描画恶意软件,有助于检测虚拟机内的威胁、查找内存中的恶意软件并帮助发现首次攻击。其二是“Security for AI”,即利用安全技术来帮助保护工作负载、模型和数据,从而使研发人员能更负责任地使用AI。英特尔软件防护扩展和英特尔可信域拓展等计算技术来助力保护客户的数据与模型。

值得一提的是,英特尔不止在第四代至强中引入了安全隔离功能,并在第五代中进一步扩展了TDX功能。

Ronak Singhal分享说,扩展TDX不仅可增强虚拟机的安全性,还可将虚拟机性能提高。这为客户提供了一种将虚拟机迁移到专为安全设计的环境的途径,同时仍能获得所需的性能。

在“推动AI无处不在”的愿景之下,英特尔院士兼数据中心与人工智能集团AI架构师Pallavi Mahajan分析,有关技术的重要性愈发突出。一是横跨数据中心、云、端和边缘的广泛的基础设施,它们对于优化AI性能至关重要。二是网络技术可实现跨计算范围的无缝通信。三是如何最小化重复工作,为整个计算领域的构建者和运营商简化AI软件的开发和部署,即“一次编写,随处部署”。拥有开放标准的AI软件能轻松实现不同AI应用间的互操性和协作性。四是如何通过多重安全措施来保护重要数据的安全,并降低风险。

瞄准于硬件和软件生态层面的精进,英特尔在AI领域的“护城河”也日渐增强。

Pallavi Mahajan详细说,通过CPU、GPU、NPU、全新英特尔酷睿Ultra和第五代至强,可为混合式AI提供全面的解决方案。而且,英特尔不断演进的OpenVINO平台支持开放的生态系统,采用单个模型的各层并将其分布在加速器上来支持异构计算和多种架构,可全面助力研发人员能够在整体的计算工作负载中,无论是在云端、客户端或是边缘,均可根据不同的KPI、延迟、成本或法规等详细情况,通过AI模型构建最佳的“无缝”体验。

为了实现从云到边缘的无缝体验,网络至关重要。Pallavi Mahajan表示,这在某种程度上预示着英特尔需要提供更具性价比,且基于开放标准的 AI Fabric。“AI Fabric”由两种不同的互连组成:将服务器连接在一起的互连技术,称为Scale-Out(横向扩展);连接每个服务器内部GPU的互连技术,称为Scale-Up(纵向扩展)。如今这些互连通常基于专有技术,客户要开放的可替代方案,以降低他们的总体拥有成本和选择成本。

提及CPU与GPU的竞夺之势,英特尔资深技术专家Allen Chu指出,GPU将继续为AI中一些最高且一直增长的工作负载提供服务,而对于在CPU上运行的大量人工智能,英特尔也正在为其提供领先的技术和创新,以使其持续应用CPU 并取得傲人的成绩,同时CPU也将持续应用于为驱动和运行数据中心的广泛工作负载中。

对于与英伟达、AMD等对手的竞争态势,Allen Chu还认为,英特尔在人工智能深度学习和大语言模型方面处于非常有利的竞争地位。当客户将 AI 工作负载进行分解时,CPU 很适合基础推理;当需要专用加速时,Gaudi很适合。总的来看,GPU正在驱动许多基础模型,而CPU则适用于驱动其中一些微调模型。得益于软件调优和英特尔的整体实力,英特尔已具备强大的竞争力。

“与AMD不同,英特尔第五代至强可扩展处理器是内置AI加速器的CPU,但AMD并没有内置加速器。而且它们无法参与软件工作,不可以进行数据服务的应用。此外,虽然AMD EPYC 3D V-Cache集成更多的缓存,但重要是这些缓存和多少核心共享,而英特尔正在考虑的是如何真正在整个CPU系统享这些缓存。”Lisa Spelman在解读与AMD产品的竞争时自信满满。

在AI江湖也在演绎“唯快不破”。第五代英特尔至强可扩展处理器还刚刚上市,下一代Granite Rapids和Sierra Forest至强处理器已在紧锣密鼓开发中,在核心数、频率等层面均有望实现新的跃升。

Allen Chu也进一步表示,英特尔正通过稳健的执行力,提升产品性能、效率提升的同时,降低TCO,并逐步推动CPU在诸多模型上的部署和应用合作。在客户实际应用过程中,英特尔了解到,只关注插槽数量和吞吐性能是远远不足的,英特尔也在持续扩展CPU在云和虚拟化等环境中的应用机会。

随着英特尔自身混合AI软硬件“堡垒”的不断坚固,英特尔在AI时代也将谱写新的篇章。

智慧芯同频共创,大模型智引未来,星宸科技2023开发者大会暨产品发布会圆满落幕